曆史

1928年,R.V.L.哈特萊提出了信息定量化的初步設想,他将符号取值數m的對數定義為信息量,即I=logm。對信息量作深入、系統研究的是信息論創始人C.E.仙農。1948年,仙農指出信源給出的符号是随機的,信源的信息量應是概率的函數,以信源的信息熵表示,即

,其中P表示信源不同種類符号的概率,i=1,2,…,n。

實質上哈特萊公式是等概率時仙農公式的特例。

基本内容實際信源多為有記憶序列信源,隻有在掌握全部序列的概率特性後,才能計算出該信源中平均一個符号的熵H(U)(L為符号數這通常是困難的。

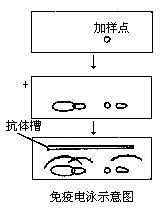

如果序列信源簡化為簡單的一階、齊次、遍曆馬氏鍊,則比較簡單。根據符号的條件概率P(即前一符号為i條件下後一符号為j的概率),可以求出遍曆信源的穩定概率P,再由P和P求出H(U)。即如圖1。

其中H(U|V)稱為條件熵,即前一符号V已知時後一符号U的不确定度。

信息量與信息熵在概念上是有區别的。在收到符号之前是不能肯定信源到底發送什麼符号,通信的目的就是使接收者在收到符号後,解除對信源存在的疑義(不确定度),使不确定度變為零。這說明接收者從發送者的信源中獲得的信息量是一個相對的量(H(U)-0)。而信息熵是描述信源本身統計特性的物理量,它表示信源産生符号的平均不确定度,不管有無接收者,它總是客觀存在的量。

從信源中一個符号V中獲取另一符号u的信息

量可用互信息表示,即

I(U;V)=H(U)-H(U|V)

表示在收到V以後仍然存在對信源符号U的疑義(不确定度)。一般情況下

I(U;V)≤H(U)

即獲得的信息量比信源給出的信息熵要小。

連續信源可有無限個取值,輸出信息量是無限大,但互信息是兩個熵值之差,是相對量。這樣,不論連續或離散信源,接收者獲取的信息量仍然保持信息的一切特性,且是有限值。

信息量的引入,使通信、信息以及相關學科得以建立在定量分析的基礎上,為各有關理論的确立與發展提供了保證。

互信息和信息熵有關,指的是兩個随機變量之間的關聯程度,即給定一個随機變量後,另一個随機變量不确定性的削弱程度,因而互信息取值最小為0,意味着給定一個随機變量對确定一另一個随機變量沒有關系(完全獨立),最大取值為随機變量的熵,意味着給定一個随機變量,能完全消除另一個随機變量的不确定性(兩個随機變量完全一緻)

簡介

所謂信息量是指從N個相等可能事件中選出一個事件所需要的信息度量或含量,也就是在辯識N個事件中特定的一個事件的過程中所需要提問"是或否"的最少次數.

香農(C.E.Shannon)信息論應用概率來描述不确定性。信息是用不确定性的量度定義的.一個消息的可能性愈小,其信息愈多;而消息的可能性愈大,則其信息愈少.事件出現的概率小,不确定性越多,信息量就大,反之則少。

信息現代定義。[2006年,醫學信息(雜志),鄧宇等].

信息是及其屬性的标示。逆維納信息定義

信息是确定性的增加。逆香農信息定義

信息是事物現象及其屬性标識的集合。2002年

在數學上,所傳輸的消息是其出現概率的單調下降函數。如從64個數中選定某一個數,提問:“是否大于32?”,則不論回答是與否,都消去了半數的可能事件,如此下去,隻要問6次這類問題,就可以從64個數中選定一個數。我們可以用二進制的6個位來記錄這一過程,就可以得到這條信息。

信息多少的量度。1928年R.V.L.哈特萊首先提出信息定量化的初步設想,他将消息數的對數定義為信息量。若信源有m種消息,且每個消息是以相等可能産生的,則該信源的信息量可表示為I=logm。但對信息量作深入而系統研究,還是從1948年C.E.香農的奠基性工作開始的。

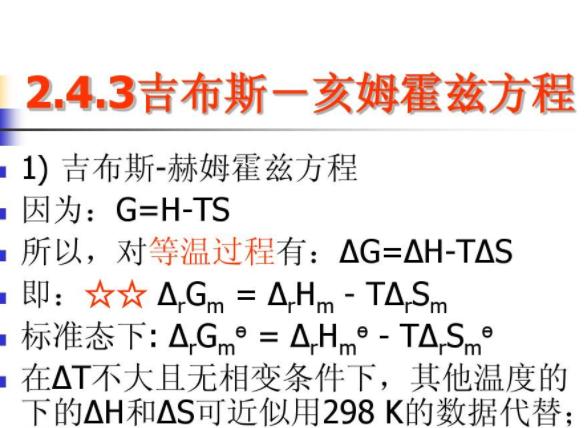

信息的統計特征描述是早在1948年香農把熱力學中熵的概念與熵增原理引入信息理論的結果。先行考察熵增原理。熱力學中的熵增原理是這樣表述的:存在一個态函數-熵,隻有不可逆過程才能使孤立系統的熵增加,而可逆過程不會改變孤立系統的熵。

從中可以看出:一、熵及熵增是系統行為;二、這個系統是孤立系統;三、熵是統計性狀态量,熵增是統計性過程量。讨論信息的熵表述時,應充分注意這些特征的存在。并且知道,給定系統中發生的信息傳播,是不可逆過程。

在信息論中,認為信源輸出的消息是随機的。即在未收到消息之前,是不能肯定信源到底發送什麼樣的消息。而通信的目的也就是要使接收者在接收到消息後,盡可能多的解除接收者對信源所存在的疑義(不定度),因此這個被解除的不定度實際上就是在通信中所要傳送的信息量。

因此,接收的信息量在無幹擾時,在數值上就等于信源的信息熵,式中P(xi)為信源取第i個符号的概率。但在概念上,信息熵與信息量是有區别的。

信息熵是描述信源本身統計特性的一個物理量。它是信源平均不定度,是信源統計特性的一個客觀表征量。不管是否有接收者它總是客觀存在的。

信息量則往往是針對接收者而言的,所謂接收者獲得了信息,是指接收者收到消息後解除了對信源的平均不定度,它具有相對性。對于信息量的說明須引入互信息的概念。

在信息論中,互信息的定義是:I(X;Y)=H(X)-H(X|Y),數式右邊後一項稱為條件熵,對離散消息可表示

,它表示已知Y以後,對X仍存在的不定度。因此,互信息I(X;Y)是表示當收到Y以後所獲得關于信源X的信息量。與互信息相對應,常稱H(X)為自信息。互信息具有三個基本性質。

①非負性:I(X;Y)≥0,僅當收到的消息與發送的消息統計獨立時,互信息才為0。

②互信息不大于信源的熵:I(X;Y)≤H(X),即接收者從信源中所獲得的信息必不大于信源本身的熵。僅當信道無噪聲時,兩者才相等。

③對稱性:I(X;Y)=I(Y;X),即Y隐含X和X隐含Y的互信息是相等的。

對于連續信源的互信息,它仍表示兩個熵的差值,所以也可直接從離散情況加以推廣,并保持上述離散情況的一切特性,即實際信源是單個消息信源的組合,所以實際信源的互信息I(X;Y)也可以直接從上述單個消息的互信息I(X;Y)加以推廣,即I(X;Y)=H(X)-H(X│Y)。配圖相關連接

發展過程

被稱為信息化社會的今天,現代情報學理論及其應用,非常注重信息量化測度。

1980年代,英國著名情報學家B.C.布魯克斯,在闡述人之信息(情報)獲取過程時,深入研究了感覺信息的接收過程,并将透視原理──對象的觀察長度Z與從觀察者到被觀察對象之間的物理距離X成反比,引入情報學,提出了Z=LogX的對數假說。

用此能較好地說明信息傳遞中,情報随時間、空間、學科(行業)的不同而呈現的對數變換。然而,關于用戶的情報搜尋行為,在其信息來源上,“獲取距離最近的比例最高,最遠的比例最低”的結論,在跨域一體、存在國際互聯網的今天,需要有新的理論進行新的概括。

對數透視變換,源于實驗心理物理學。1846年德國心理學家E.H.Weber提出了韋伯公式:△I/I=k。

這裡,△I代表剛可感覺到的差别阈限,I代表标準刺激物理量,k是小于1的常數。後來,Fechner把這個關于差别阈限的規律稱之為韋伯定律,并于1860年在此基礎上提出了著名的費肯納對數定律:心理的感覺量值S是物理刺激量I的對數函數,即S=cLogI,c是由特殊感覺方式确定的常數。

1957年Stevens提出幂定律:S=bIa,a與b為特征常數。

心理物理函數究竟是服從幂定律還是服從對數定律?W.S.Togerson認為,這不能通過實驗解決,而是一個在實驗中進行選擇的問題。G.Ekman在假定Fechner的對數定律是普遍正确的前提下,推導出幂定律是對數定律的一個特例。

中國有突出貢獻的科學家程世權,在1990年出版的《模糊決策分析》一書中,評介引述于宏義等對“系統的定性和定量轉化,總結歸納出了一種方便可行、科學可靠的定性排序與定量轉化的方法”。

于宏義等之方法,在利用顯在的頻數信息的同時,巧妙利用了潛在的泛序信息——權數,使模糊系統簡便有效地轉化成明晰的工程系統。其測度模式是:

F(I)=Ln(max{I}-I+2)/Ln(max{I}+1)。

式中,I為所論對象按一定指标的排序序号,F(I)為其隸屬度。實際應用中巧妙運用“自動連鎖”機制,确實簡便、實用、有效。所謂“自動連鎖”機制,就是“評價者在評價他人他事他物的同時,不能不表現自身,不能不被評價”。