简介

1948年

香农在Bell System Technical Journal上发表了《A Mathematical Theory of Communication》。论文由香农和威沃共同署名。这篇奠基性的论文是建立在香农对通信的观察上,即“通信的根本问题是报文的再生,在某一点与另外选择的一点上报文应该精确地或者近似地重现”。这篇论文建立了信息论这一学科,给出了通信系统的线性示意模型,即信息源、发送者、信道、接收者、信息宿,这是一个新思想。此后,通信就考虑为把电磁波发送到信道中,通过发送1和0的比特流,人们可以传输图像、文字、声音等等。今天这已司空见惯,但在当时是相当新鲜的。他建立的信息理论框架和术语已经成为技术标准。他的理论在通信工程师中立即获得成功,并刺激了今天信息时代所需要的技术发展。

名称由来

信息论将信息的传递作为一种统计现象来考虑,给出了估算通信信道容量的方法。信息传输和信息压缩是信息论研究中的两大领域。这两个方面又由信息传输定理、信源-信道隔离定理相互联系。

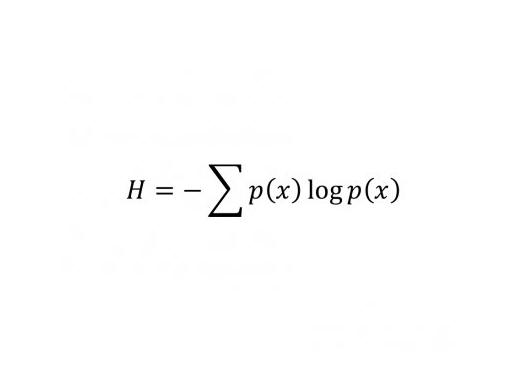

这一定义可以用来推算传递经二进制编码后的原信息所需的信道带宽。熵度量的是消息中所含的信息量,其中去除了由消息的固有结构所决定的部分,比如,语言结构的冗余性以及语言中字母、词的使用频度等统计特性。

信息论中熵的概念与物理学中的热力学熵有着紧密的联系。玻耳兹曼与吉布斯在统计物理学中对熵做了很多的工作。信息论中的熵也正是受之启发。

互信息(Mutual Information)是另一有用的信息度量,它是指两个事件集合之间的相关性。两个事件X和Y的互信息定义为:

I(X,Y)=H(X)+H(Y)-H(X,Y)

其中H(X,Y)是联合熵(Joint Entropy),其定义为:

H(X,Y)=-∑p(x,y)logp(x,y)

x,y

互信息与多元对数似然比检验以及皮尔森χ2校验有着密切的联系

背景信息

20世纪中叶,信息论、控制论、系统论等标新立异的新理论相继问世,有力地“晃动”着传统的科学框架。克劳德·香农是一位美国数学工程师,作为信息论的创始人,人们认为他是20世纪最伟大的科学家之一。

他在通信技术与工程方面的创造性工作,为计算机与远程通信奠定了坚实的理论基础。人们尊崇香农为信息论及数字通信时代的奠基之父。确实,他对人类的贡献超过了一般的诺贝尔获奖者。回顾20世纪的信息革命风暴,经他阐明的信息概念、连同“比特”这个单位已经深入人心,成为今天日常生活都离不开的词汇。

主要内容

熵的概念

香农理论的重要特征是熵(entropy)的概念,他证明熵与信息内容的不确定程度有等价关系。熵曾经是波尔兹曼在热力学第二定律引入的概念,我们可以把它理解为分子运动的混乱度。信息熵也有类似意义,例如在中文信息处理时,汉字的静态平均信息熵比较大,中文是9.65比特,英文是4.03比特。这表明中文的复杂程度高于英文,反映了中文词义丰富、行文简练,但处理难度也大。信息熵大,意味着不确定性也大。因此我们应该深入研究,以寻求中文信息处理的深层突破。不能盲目认为汉字是世界上最优美的文字,从而引申出汉字最容易处理的错误结论。

众所周知,质量、能量和信息量是三个非常重要的量。

人们很早就知道用秤或者天平计量物质的质量大小。然而,我们关于热、燃料、功与能的计量问题,迟至19世纪中叶,随着热功当量的明确和能量守恒定律的建立才逐渐清楚。能量一词就是它们的总称,而能量的计量则通过“卡、焦耳”等新单位的出现而得到解决。

然而,关于文字、数字、图画、声音的知识已有几千年历史了。但是它们的总称是什么,它们如何统一地计量,直到19世纪末还没有被正确地提出来,更谈不上如何去解决了。20世纪初期,随着电报、电话、照片、电视、无线电、雷达等的发展,如何计量信号中信息量的问题被隐约地提上日程。

1928年哈特利(R.V. H. Harley)考虑到从D个彼此不同的符号中取出N个符号并且组成一个“词”的问题。如果各个符号出现的概率相同,而且是完全随机选取的,就可以得到DN个不同的词。从这些词里取了特定的一个就对应一个信息量I。哈特利建议用N log D这个量表示信息量,即I=NlogD。这里的log表示以10为底的对数。后来,1949年控制论的创始人维纳也研究了度量信息的问题,还把它引向热力学第二定律。

但是就信息传输给出基本数学模型的核心人物还是香农。1948年香农长达数十页的论文“通信的数学理论”成了信息论正式诞生的里程碑。在他的通信数学模型中,清楚地提出信息的度量问题,他把哈特利的公式扩大到概率pi不同的情况,得到了著名的计算信息熵H的公式:H=∑-pi log pi

如果计算中的对数log是以2为底的,那么计算出来的信息熵就以比特(bit)为单位。今天在电脑和通信中广泛使用的字节(Byte)、KB、MB、GB等词都是从比特演化而来。“比特”的出现标志着人类知道了如何计量信息量。香农的信息论为明确什么是信息量概念作出决定性的贡献。

事实上,香农最初的动机是把电话中的噪音除掉,他给出通信速率的上限,这个结论首先用在电话上,后来用到光纤,现在又用在无线通信上。我们今天能够清晰地打越洋电话或卫星电话,都与通信信道质量的改善密切相关。

应用范围

编码学

密码学与密码分析学

数据传输

数据压缩

检测理论

估计理论

政治学(政治沟通)

信息论概述

信息论是一门用数理统计方法来研究信息的度量、传递和变换规律的科学。它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

科学意义

于是在20世纪中叶,人类终于对三个非常重要的概念:质量、能量、信息量都有了定量的计量办法。我们应该牢记,为阐明质量概念做出伟大贡献的是发现物体力学定律的牛顿(Sir Isaac Newton,1642-1727),为阐明能量概念作出伟大贡献的是热力学第一定律的发现者们:迈耳(Julius Robert von Mayer,1814-1878)、焦耳(James Prescott Joule,1818-1899)、赫尔姆霍兹(Hermann von Helmholtz,1821-1894)、开尔文(Lord Kelvin,1824-1907),而为阐明信息概念作出伟大贡献的就是香农。

20世纪中期随着原子弹的出现,物理学成为最荣耀的科学学科。在随后的50年里,晶体管、人造卫星、集成电路、电脑的飞跃发展无不与物理学知识的应用有关。但是我们也惊奇地发现这些新技术都是为提高信息的处理能力服务。光荣的物理学家们忙了半个世纪,终于发现自己仅是给信息科学当仆人。信息量能进入物理学吗?但“信息不是物质”!在物理学的版图中人们不知道把信息论放到哪里合适。人类知识体现的这种新的混乱局面需要我们不断地澄清。

后来,他在人工智能方面也做了许多工作。例如他设计了一个电子老鼠来解决迷宫问题。他还研究过四色问题。他设计了国际象棋程序,发表在1950年的论文《Programming a computer for playing chess》中。1956年在洛斯阿拉莫斯的MANIAC计算机上实现了一个国际象棋的下棋程序。这一年香农还发表论文说明通用图灵机可以仅用两个状态构建。