簡介

梯度:對于可微的數量場,以為分量的向量場稱為f的梯度或斜量。

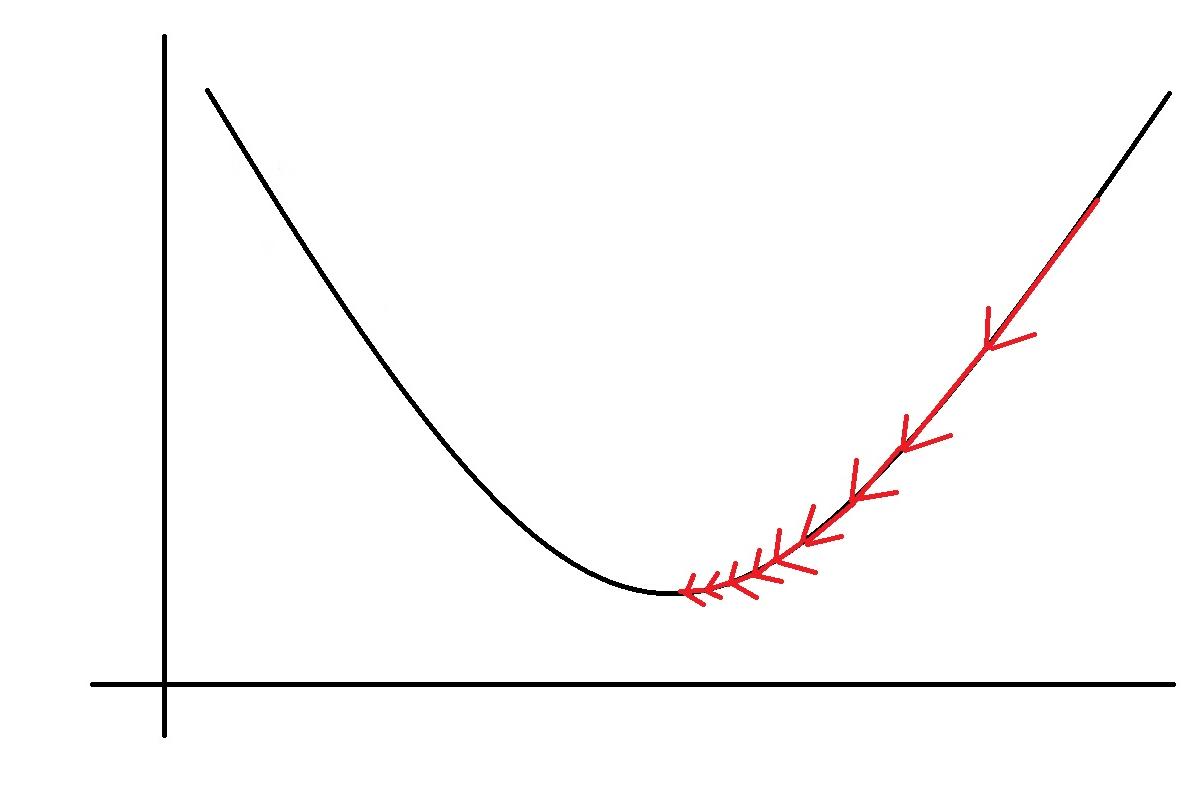

梯度下降法(gradient descent)是一個最優化算法,常用于機器學習和人工智能當中用來遞歸性地逼近最小偏差模型。

求解過程

顧名思義,梯度下降法的計算過程就是沿梯度下降的方向求解極小值(也可以沿梯度上升方向求解極大值)。

其叠代公式為 ,其中 代表梯度負方向, 表示梯度方向上的搜索步長。梯度方向我們可以通過對函數求導得到,步長的确定比較麻煩,太大了的話可能會發散,太小收斂速度又太慢。一般确定步長的方法是由線性搜索算法來确定,即把下一個點的坐标看做是ak+1的函數,然後求滿足f(ak+1)的最小值的ak+1即可。

因為一般情況下,梯度向量為0的話說明是到了一個極值點,此時梯度的幅值也為0.而采用梯度下降算法進行最優化求解時,算法叠代的終止條件是梯度向量的幅值接近0即可,可以設置個非常小的常數阈值。

應用

舉一個非常簡單的例子,如求函數 的最小值。

利用梯度下降的方法解題步驟如下:

1、求梯度,

2、向梯度相反的方向移動 ,如下

,其中, 為步長。如果步長足夠小,則可以保證每一次叠代都在減小,但可能導緻收斂太慢,如果步長太大,則不能保證每一次叠代都減少,也不能保證收斂。

3、循環叠代步驟2,直到 的值變化到使得 在兩次叠代之間的差值足夠小,比如0.00000001,也就是說,直到兩次叠代計算出來的 基本沒有變化,則說明此時 已經達到局部最小值了。

4、此時,輸出 ,這個 就是使得函數 最小時的 的取值 。

MATLAB如下。

梯度下降法處理一些複雜的非線性函數會出現問題,如Rosenbrock函數:,其最小值在 處,函數值為 。但是此函數具有狹窄彎曲的山谷,最小點 就在這些山谷之中,并且谷底很平。優化過程是之字形的向極小值點靠近,速度非常緩慢。

缺點

靠近極小值時收斂速度減慢。

直線搜索時可能會産生一些問題。

可能會“之字形”地下降。